Viés algorítmico: a IA pode potencializar o racismo e a desigualdade?

Quero começar esse artigo te propondo um rápido exercício. Busque no Google Imagens por “homem foto”. Analise os resultados e reflita: qual é o padrão que emerge? Agora busque por “mulher foto” e faça a mesma pergunta. Não preciso ser vidente para afirmar que, muito provavelmente, os seus resultados de pesquisa retornaram uma grande porcentagem de homens e mulheres brancos.

Isso acontece porque existe um viés nos resultados das buscas. O algoritmo desses mecanismos foram treinados com um conjunto de dados que não representam adequadamente a diversidade da população. Esses dados são geralmente enviesados em relação a certas características, como raça, gênero ou origem étnica. A esse fenômeno damos o nome de viés algorítmico, um desafio complexo ainda pouco debatido em meio à febre das IAs generativas.

O viés discriminatório nas IAs é uma preocupação crescente à medida que essas tecnologias se tornam mais amplamente utilizadas em uma variedade de domínios, incluindo aplicação da lei, finanças, saúde, emprego e muito mais. Ao negligenciar aspectos de diversidade, equidade e inclusão na construção de modelos de IA corremos o risco de perpetuar preconceitos históricos e potencializar desigualdades sistêmicas.

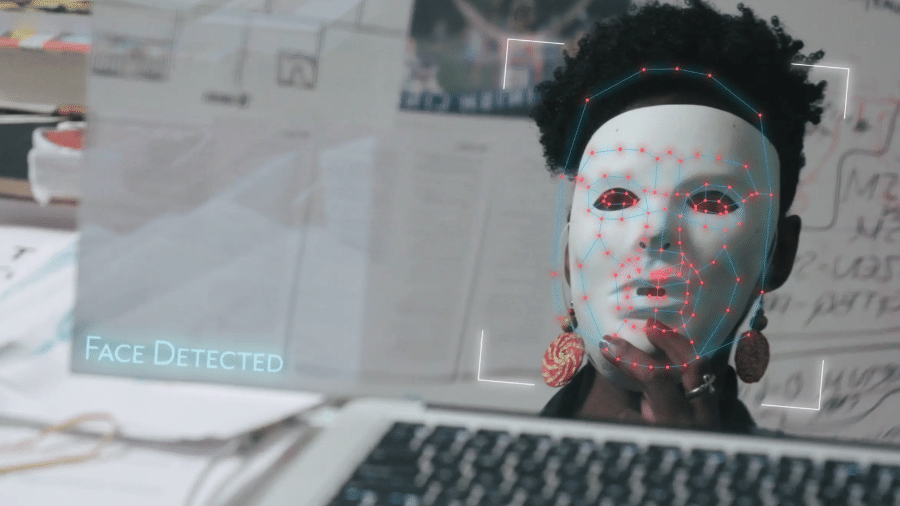

Este é um tema bastante quente e complexo. Caso não tenha nenhuma familiaridade com o assunto, recomendo que assista ao documentário Coded Bias, disponível na Netflix. O documentário examina o viés discriminatório presente nos algoritmos de Inteligência Artificial e suas implicações na sociedade. Em Coded Bias seguimos a história de Joy Buolamwini, uma pesquisadora do MIT, enquanto ela descobre e expõe como os sistemas de reconhecimento facial têm dificuldade em identificar com precisão pessoas de pele preta e mulheres, devido aos conjuntos de dados enviesados usados em seu treinamento. Por meio de sua pesquisa, Joy Buolamwini comprova o viés racista dessas aplicações.

As principais causas do viés algorítmico estão profundamente enraizadas nas práticas de coleta e utilização de dados, na formulação dos próprios algoritmos e nas interações dos usuários com os sistemas de IA. Um dos fatores primordiais é o viés nos dados de treinamento, uma vez que conjuntos de dados históricos frequentemente refletem desigualdades sociais existentes. Por exemplo, sistemas de reconhecimento facial podem mostrar taxas desiguais de precisão entre diferentes grupos étnicos devido à sub-representação de indivíduos de certos grupos nos conjuntos de dados de treinamento.

Além disso, a formulação dos algoritmos pode introduzir viés quando certas variáveis são ponderadas de forma desproporcional ou quando são incorporadas suposições culturais ou sociais. Por exemplo, algoritmos de recrutamento que favorecem candidatos com determinadas experiências acadêmicas podem perpetuar vieses de classe. Os feedbacks enviesados dos usuários também desempenham um papel crucial, onde sistemas de recomendação online podem reforçar preferências preexistentes ao sugerir conteúdo semelhante ao que o usuário já consumiu. Por fim, o viés na avaliação de desempenho pode surgir quando as métricas utilizadas para medir o sucesso dos modelos não levam em consideração aspectos de equidade e justiça. Essas causas se entrelaçam e, quando não são abordadas, podem resultar em sistemas de IA que perpetuam e amplificam desigualdades em vez de mitigá-las.

As implicações do viés algorítmico são amplas e impactam diversos aspectos da sociedade, desde questões sociais até econômicas e éticas. Em sistemas de reconhecimento facial, por exemplo, isso pode ter sérias consequências, como falsas acusações criminais ou negação de acesso a serviços com base em identificações incorretas. Além disso, o IA Index Report realizado pelo Stanford Institute for Human-Centered Artificial Intelligence (HAI) revelou que as ferramentas de inteligência artificial utilizadas nos processos de recrutamento e seleção frequentemente mantêm vieses inconscientes. Como consequência, pessoas diversas podem ser injustamente excluídas desses processos.

No setor financeiro, sistemas automatizados de concessão de crédito podem negar oportunidades a grupos minoritários com base em algoritmos que subestimam sua capacidade de pagamento, ampliando disparidades econômicas. Um relatório de 2021 da National Community Reinvestment Coalition nos Estados Unidos comprova o viés discriminatório das IAs. Segundo o relatório, a taxa de pessoas negras com pedidos de empréstimos negados foi duas vezes maior do que a taxa de pedidos negados a pessoas brancas, mesmo quando consideradas variáveis como renda, valor do empréstimo e localização do imóvel.

Mitigar o viés algorítmico é um desafio complexo, mas crucial. Uma abordagem fundamental é garantir a diversidade, a equidade e a inclusão em todas as etapas de construção e operação dessas aplicações de IA. Antes de mais nada, isso envolve contar com equipes de desenvolvimento mais diversas e inclusivas, em termos de gênero, etnia, idade, cultura e experiência profissional. Promover a colaboração entre pessoas diversas e garantir que seus pontos de vista sejam considerados são ações que ajudam a minimizar os vieses.

Aumentar a representatividade dos conjuntos de dados utilizados no treinamento dos modelos de IA também é essencial. Isso pode envolver a coleta de dados mais abrangentes e inclusivos e a implementação de técnicas de pré-processamento para identificar e corrigir vieses existentes nos dados. Além disso, é essencial examinar criticamente as formulações dos algoritmos para identificar e mitigar suposições implícitas que possam introduzir viés. A cientista de dados Cathy O’Neil em seu livro “Armas de Destruição Matemática” reforça que a questão ética e moral em relação à seleção dos dados utilizados nesses modelos precisa ser sempre considerada:

“Os dados não vão desaparecer. Nem os computadores e muito menos a matemática. Modelos preditivos são, cada vez mais, as ferramentas com as quais contaremos para comandar nossas instituições, alocar nossos recursos e gerenciar nossas vidas”, cita a autora. “Mas esses modelos são construídos não apenas a partir de dados, mas também de escolhas que fazemos sobre quais dados devemos considerar — e quais não. Essas escolhas não são apenas sobre logística, lucro e eficiência. Elas são fundamentalmente uma questão moral.”

A transparência também desempenha um papel fundamental na mitigação do viés algorítmico, permitindo que os usuários compreendam como os algoritmos tomam decisões e identifiquem e corrijam vieses quando necessário. Ademais, avançar nas temáticas de regulamentação é imperativo. Precisamos construir leis e normas éticas rigorosas para o desenvolvimento e uso dessas tecnologias.

O viés algorítmico representa um desafio significativo na era da IA, com implicações profundas em várias esferas da sociedade. À medida que nos esforçamos para aproveitar os benefícios da IA, precisamos abordar proativamente esse problema, garantindo que nossos sistemas de IA sejam justos, inclusivos e equitativos. Somente através de esforços colaborativos e abordagens centradas nas pessoas podemos mitigar eficazmente o viés algorítmico e construir um futuro onde a IA realmente beneficie a todos.

Carolina Thaines — Head de Inovação na Gok

A GOK é uma aceleradora de inovação e tecnologia para empresas. Atuamos desde estratégias digitais revolucionárias até a eficaz implementação de soluções. Com uma abordagem personalizada e foco em resultados, somos o seu parceiro ideal para navegar pelo futuro da inovação e tecnologia.